Esta guía ilustrará el proceso de uso del gráfico de conocimiento de conversación en LangChain.

¿Cómo utilizar el gráfico de conocimiento de conversaciones en LangChain?

El ConversaciónKGMemoria La biblioteca se puede utilizar para recrear la memoria que se puede utilizar para obtener el contexto de la interacción. Para conocer el proceso de uso del gráfico de conocimiento de conversación en LangChain, simplemente siga los pasos enumerados:

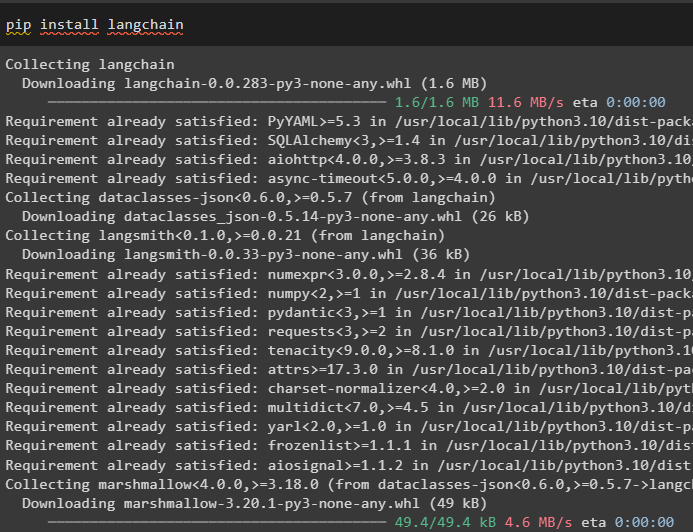

Paso 1: instalar módulos

Primero, comience con el proceso de uso del gráfico de conocimiento de la conversación instalando el módulo LangChain:

pip instalar cadena larga

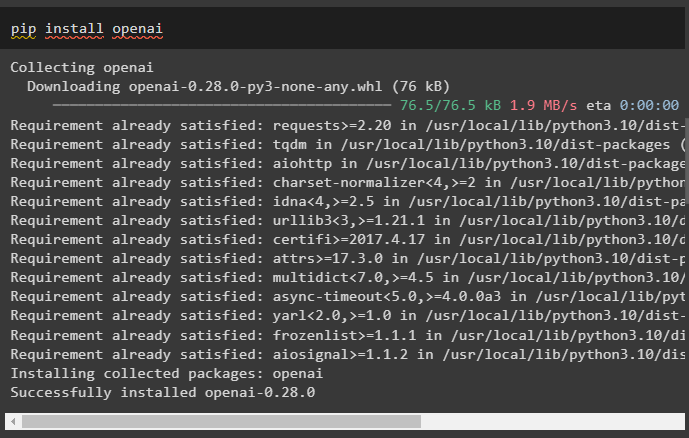

Instale el módulo OpenAI que se puede instalar usando el comando pip para obtener sus bibliotecas para crear modelos de lenguaje grandes:

instalación de pip en openai

Ahora, configurar el entorno utilizando la clave API de OpenAI que se puede generar desde su cuenta:

importar tú

importar conseguir pase

tú . alrededor de [ 'OPENAI_API_KEY' ] = conseguir pase . conseguir pase ( 'Clave API de OpenAI:' )

Paso 2: uso de la memoria con LLM

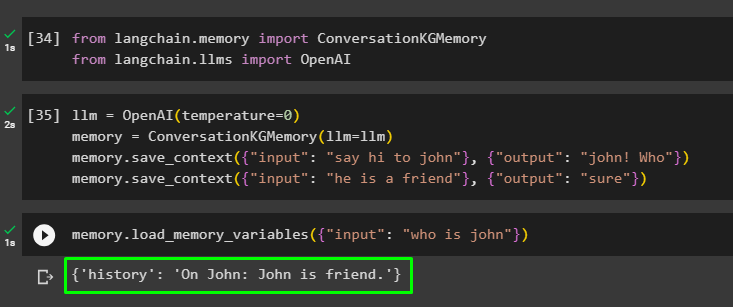

Una vez instalados los módulos, comience a usar la memoria con LLM importando las bibliotecas requeridas desde el módulo LangChain:

de cadena larga. memoria importar ConversaciónKGMemoriade cadena larga. llms importar AbiertoAI

Construya el LLM usando el método OpenAI() y configure la memoria usando el ConversaciónKGMemoria () método. Después de eso, guarde las plantillas de mensajes usando múltiples entradas con su respectiva respuesta para entrenar el modelo con estos datos:

llm = AbiertoAI ( temperatura = 0 )memoria = ConversaciónKGMemoria ( llm = llm )

memoria. guardar_contexto ( { 'aporte' : 'saluda a john' } , { 'producción' : '¡Juan! ¿Quién?' } )

memoria. guardar_contexto ( { 'aporte' : 'el es un amigo' } , { 'producción' : 'seguro' } )

Pruebe la memoria cargando el variables_memoria () Método que utiliza la consulta relacionada con los datos anteriores:

memoria. variables_memoria_carga ( { 'aporte' : '¿Quién es Juan?' } )

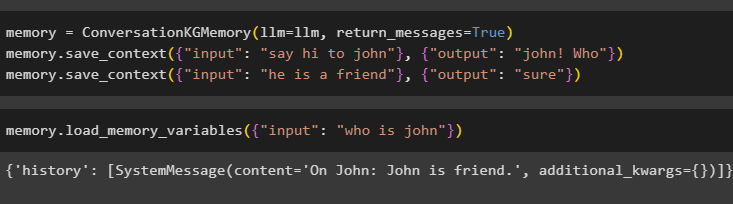

Configure la memoria usando el método ConversationKGMemory() con el mensajes_devueltos argumento para obtener el historial de la entrada también:

memoria = ConversaciónKGMemoria ( llm = llm , mensajes_devueltos = Verdadero )memoria. guardar_contexto ( { 'aporte' : 'saluda a john' } , { 'producción' : '¡Juan! ¿Quién?' } )

memoria. guardar_contexto ( { 'aporte' : 'el es un amigo' } , { 'producción' : 'seguro' } )

Simplemente pruebe la memoria proporcionando el argumento de entrada con su valor en forma de consulta:

memoria. variables_memoria_carga ( { 'aporte' : '¿Quién es Juan?' } )

Ahora, pruebe la memoria haciendo la pregunta que no se menciona en los datos de entrenamiento y el modelo no tiene idea de la respuesta:

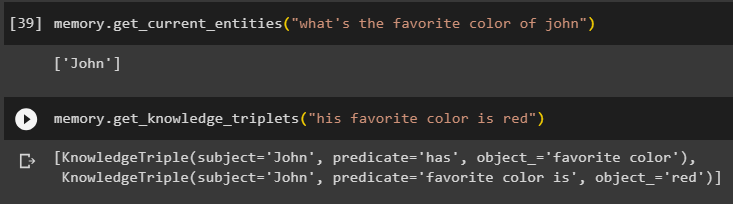

memoria. obtener_entidades_actuales ( '¿Cuál es el color favorito de John?' )Utilizar el get_knowledge_tripletes () método respondiendo a la consulta realizada anteriormente:

memoria. get_knowledge_tripletes ( 'su color favorito es el rojo' )

Paso 3: usar la memoria en cadena

El siguiente paso utiliza la memoria de conversación con las cadenas para construir el modelo LLM usando el método OpenAI(). Después de eso, configure la plantilla de mensaje usando la estructura de conversación y el texto se mostrará mientras el modelo obtiene el resultado:

llm = AbiertoAI ( temperatura = 0 )de cadena larga. indicaciones . inmediato importar Plantilla de aviso

de cadena larga. cadenas importar Cadena de conversación

plantilla = '''Esta es la plantilla para la interacción entre humanos y máquinas.

El sistema es un modelo de IA que puede hablar o extraer información sobre múltiples aspectos.

Si no entiende la pregunta o no tiene la respuesta, simplemente lo dice.

El sistema extrae datos almacenados en la sección 'Específicos' y no alucina

Específico:

{historia}

Conversación:

Humano: {entrada}

AI:'''

#Configurar la plantilla o estructura para proporcionar indicaciones y obtener respuesta del sistema de IA

inmediato = Plantilla de aviso ( variables_entrada = [ 'historia' , 'aporte' ] , plantilla = plantilla )

conversación_con_kg = Cadena de conversación (

llm = llm , verboso = Verdadero , inmediato = inmediato , memoria = ConversaciónKGMemoria ( llm = llm )

)

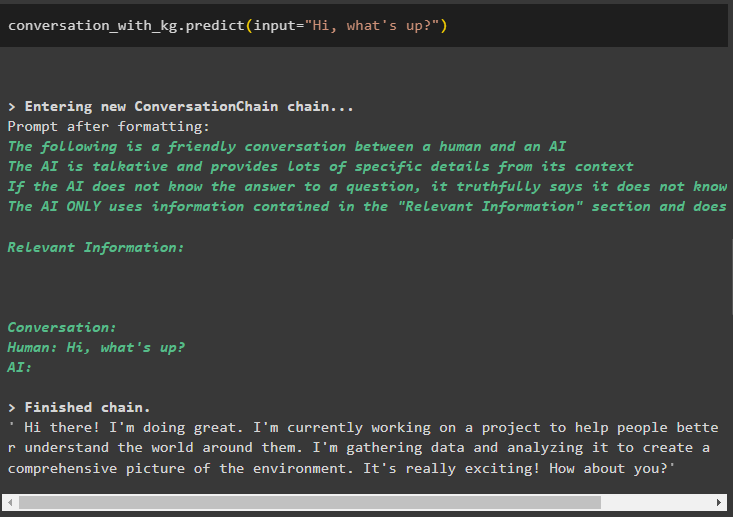

Una vez creado el modelo, simplemente llame al conversación_con_kg modelo utilizando el método predict() con la consulta realizada por el usuario:

conversación_con_kg. predecir ( aporte = '¿Hola que tal?' )

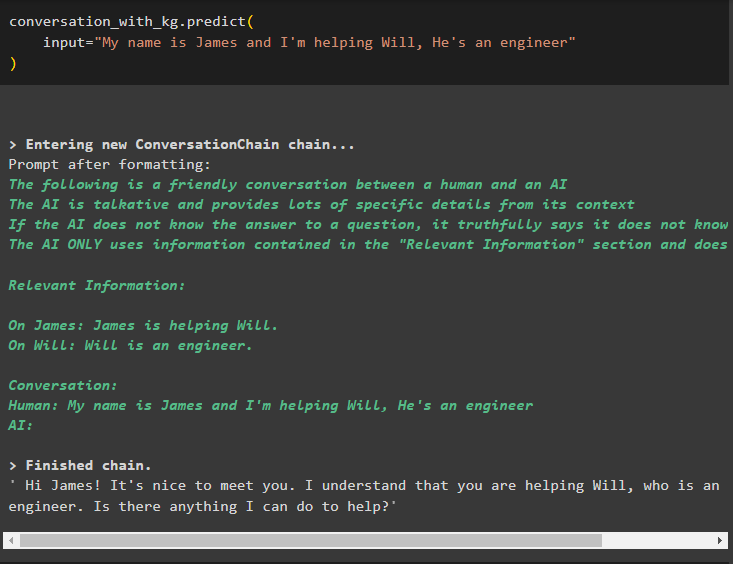

Ahora, entrene el modelo usando la memoria de conversación proporcionando la información como argumento de entrada para el método:

conversación_con_kg. predecir (aporte = 'Mi nombre es James y estoy ayudando a Will, él es ingeniero'

)

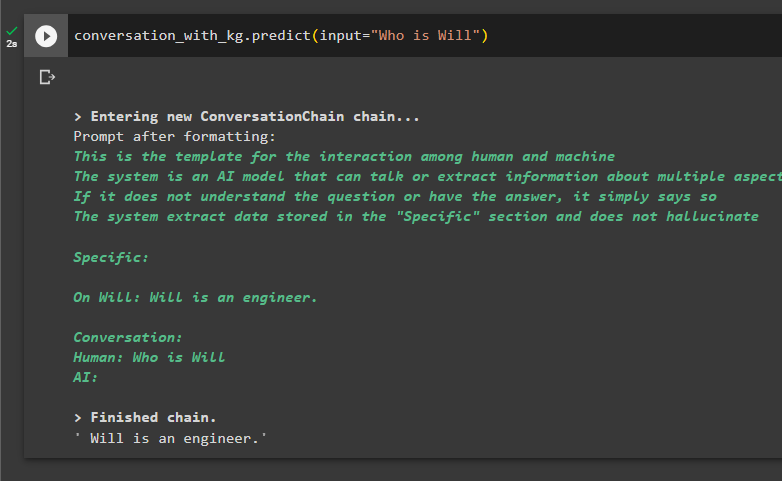

Este es el momento de probar el modelo realizando consultas para extraer información de los datos:

conversación_con_kg. predecir ( aporte = '¿Quién es voluntad?' )

Se trata de utilizar el gráfico de conocimiento de la conversación en LangChain.

Conclusión

Para utilizar el gráfico de conocimiento de conversación en LangChain, instale los módulos o marcos para importar bibliotecas para usar el método ConversationKGMemory(). Después de eso, construye el modelo usando la memoria para construir las cadenas y extraer información de los datos de entrenamiento proporcionados en la configuración. Esta guía ha detallado el proceso de uso del gráfico de conocimiento de conversación en LangChain.