Sintaxis:

Existe una variedad de servicios que brinda Hugging Face, pero uno de sus servicios más utilizados es 'API'. La API permite la interacción de la IA preentrenada y los grandes modelos de lenguaje con diferentes aplicaciones. Hugging Face proporciona las API para diferentes modelos que se enumeran a continuación:

- Modelos de generación de texto

- Modelos de traducción

- Modelos para el análisis de los sentimientos

- Modelos para el desarrollo de agentes virtuales (chatbots inteligentes)

- Clasificación y modelos de regresión

Ahora descubramos el método para obtener nuestra API de inferencia personalizada de Hugging Face. Para ello, primero tenemos que empezar por registrarnos en la web oficial de Hugging Face. Únase a esta comunidad de Hugging Face registrándose en este sitio web con sus credenciales.

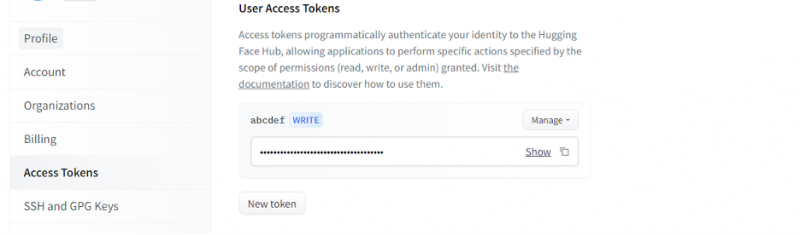

Una vez que obtengamos una cuenta en Hugging Face, ahora tenemos que solicitar la API de inferencia. Para solicitar la API, vaya a la configuración de la cuenta y seleccione el 'Token de acceso'. Una nueva ventana se abrirá. Seleccione la opción 'Nuevo token' y luego genere el token proporcionando primero el nombre del token y su función como 'ESCRIBIR'. Se genera un nuevo token. Ahora, debemos guardar este token. Hasta este punto, tenemos nuestra ficha de Hugging Face. En el siguiente ejemplo, veremos cómo podemos usar este token para obtener una API de inferencia.

Ejemplo 1: cómo crear un prototipo con la API de inferencia de Hugging Face

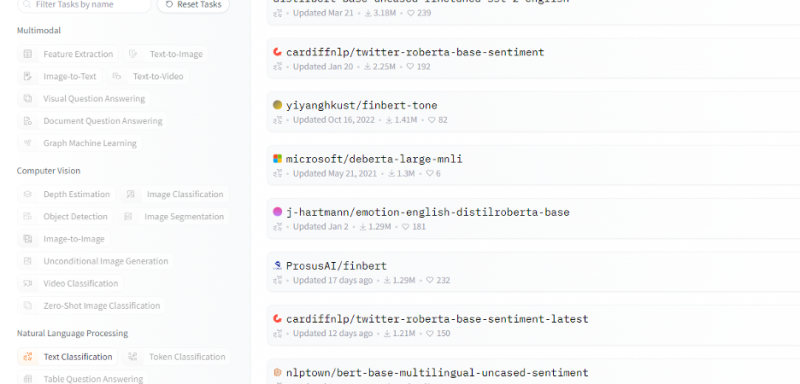

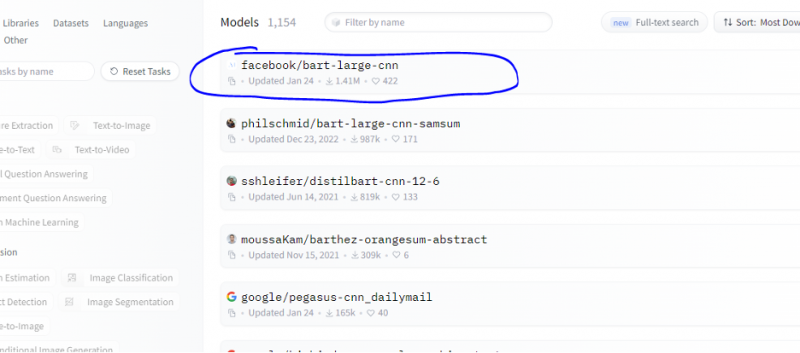

Hasta ahora, discutimos el método sobre cómo comenzar con Hugging Face e inicializamos un token de Hugging Face. Este ejemplo muestra cómo podemos usar este token recién generado para obtener una API de inferencia para un modelo específico (aprendizaje automático) y hacer predicciones a través de él. Desde la página de inicio de Hugging Face, seleccione cualquier modelo con el que desee trabajar que sea relevante para su problema. Digamos que queremos trabajar con la clasificación de texto o el modelo de análisis de sentimientos como se muestra en el siguiente fragmento de la lista de estos modelos:

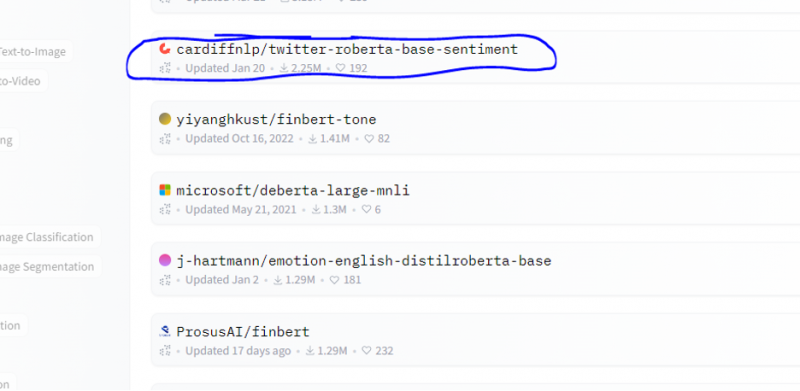

Elegimos el modelo de análisis de sentimiento de este modelo.

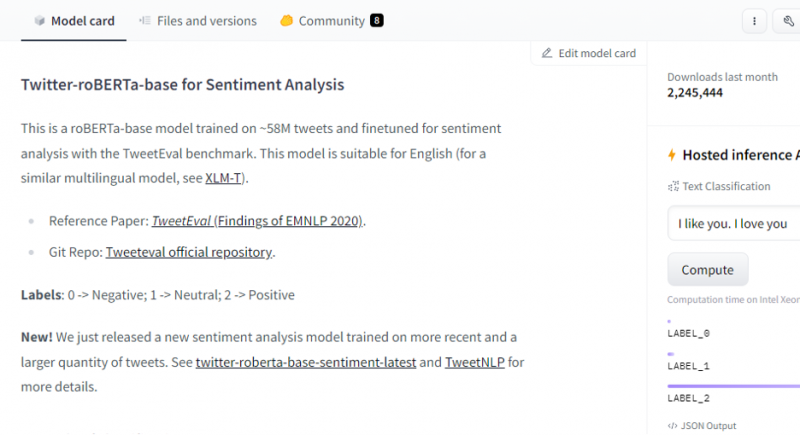

Después de seleccionar el modelo, aparecerá su tarjeta de modelo. Esta tarjeta modelo contiene información sobre los detalles de entrenamiento del modelo y qué características tiene el modelo. Nuestro modelo es roBERTa-base, que se entrena en los 58 millones de tweets para el análisis de sentimientos. Este modelo tiene tres etiquetas de clase principales y clasifica cada entrada en sus etiquetas de clase relevantes.

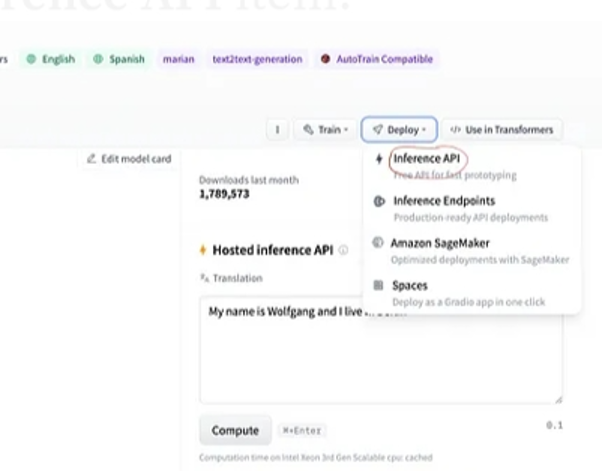

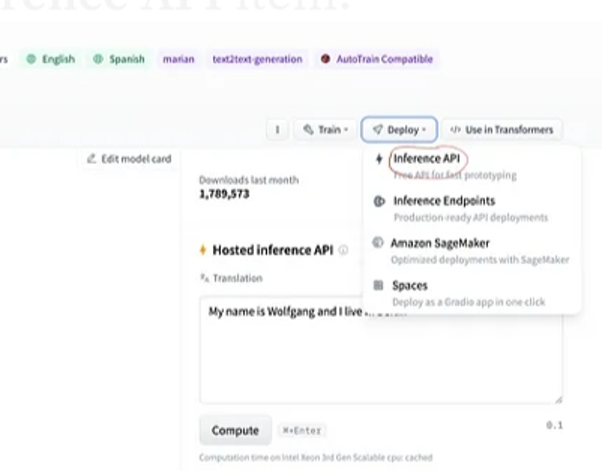

Después de la selección del modelo, si seleccionamos el botón de implementación que se encuentra en la esquina superior derecha de la ventana, se abre un menú desplegable. Desde este menú, debemos seleccionar la opción 'API de inferencia'.

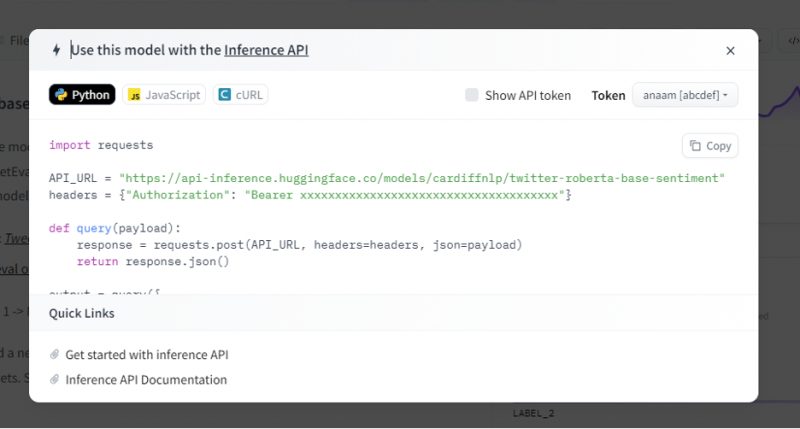

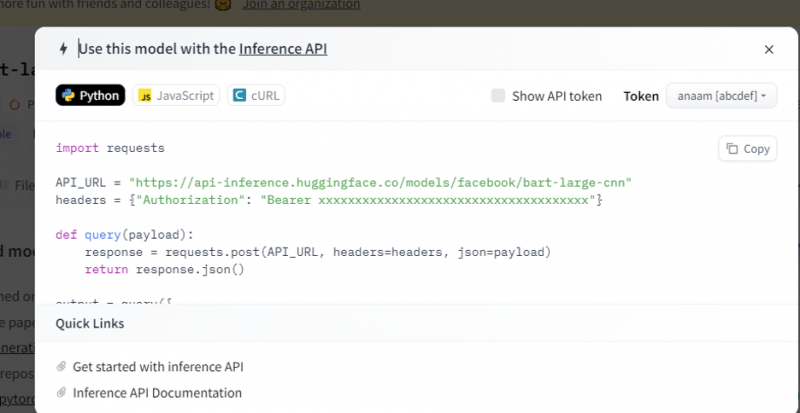

Luego, la API de inferencia proporciona una explicación completa de cómo usar este modelo específico con esta inferencia y nos permite crear rápidamente el prototipo para el modelo de IA. La ventana de la API de inferencia muestra el código que está escrito en el script de Python.

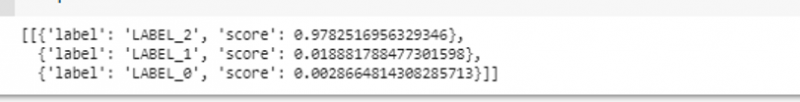

Copiamos este código y ejecutamos este código en cualquiera de los IDE de Python. Usamos Google Colab para esto. Después de ejecutar este código en el shell de Python, devuelve un resultado que viene con la puntuación y la predicción de la etiqueta. Esta etiqueta y puntaje se dan de acuerdo con nuestra entrada ya que elegimos el modelo de 'análisis de sentimiento de texto'. Luego, la entrada que le damos al modelo es una oración positiva y el modelo se entrenó previamente en tres clases de etiquetas: la etiqueta 0 implica negativa, la etiqueta 1 implica neutral y la etiqueta 2 se establece en positiva. Dado que nuestra entrada es una oración positiva, la predicción de puntaje del modelo es mayor que las otras dos etiquetas, lo que significa que el modelo predijo la oración como 'positiva'.

importar peticionesAPI_URL = 'https://api-inference.huggingface.co/models/cardiffnlp/twitter-roberta-base-sentiment'

encabezados = { 'Autorización' : 'Portador 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' }

definitivamente consulta ( carga útil ) :

respuesta = peticiones. correo ( API_URL , encabezados = encabezados , json = carga útil )

devolver respuesta. json ( )

producción = consulta ( {

'entradas' : 'Me siento bien cuando estás conmigo' ,

} )

Producción:

Ejemplo 2: Modelo de resumen a través de inferencia

Seguimos los mismos pasos que se muestran en el ejemplo anterior y creamos un prototipo del bus del modelo de resumen utilizando su API de inferencia de Hugging Face. El modelo de resumen es un modelo preentrenado que resume todo el texto que le damos como entrada. Vaya a la cuenta Hugging Face, haga clic en el modelo de la barra de menú superior y luego elija el modelo que sea relevante para el resumen, selecciónelo y lea atentamente su tarjeta de modelo.

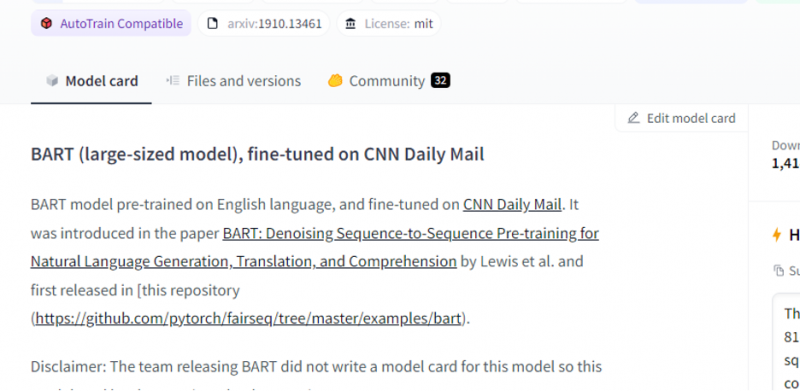

El modelo que elegimos es un modelo BART preentrenado y está finamente ajustado al conjunto de datos CNN dail mail. BART es un modelo que es más similar al modelo BERT que tiene un codificador y decodificador. Este modelo es efectivo cuando está ajustado para tareas de comprensión, resumen, traducción y generación de texto.

Luego, elija el botón 'implementación' en la esquina superior derecha y seleccione la API de inferencia en el menú desplegable. La API de inferencia abre otra ventana que contiene el código y las instrucciones para usar este modelo con esta inferencia.

Copie este código y ejecútelo en un shell de Python.

El modelo devuelve la salida, que es el resumen de la entrada que le proporcionamos.

Conclusión

Trabajamos en la API de inferencia Hugging Face y aprendimos cómo podemos usar la interfaz programable de esta aplicación para trabajar con los modelos de lenguaje previamente entrenados. Los dos ejemplos que hicimos en el artículo se basaron principalmente en los modelos de PNL. Hugging Face API puede hacer maravillas si queremos desarrollar un prototipo rápido al proporcionar la integración rápida de modelos de IA en nuestras aplicaciones. En resumen, Hugging Face tiene soluciones para todos sus problemas, desde el aprendizaje por refuerzo hasta la visión artificial.