Esta guía ilustrará el proceso de ejecución de LLMChains en LangChain.

¿Cómo ejecutar LLMChains en LangChain?

LangChain proporciona las funciones o dependencias para crear LLMChains utilizando LLM/Chatbots y plantillas de mensajes. Para conocer el proceso de creación y ejecución de LLMChains en LangChain, simplemente siga la siguiente guía paso a paso:

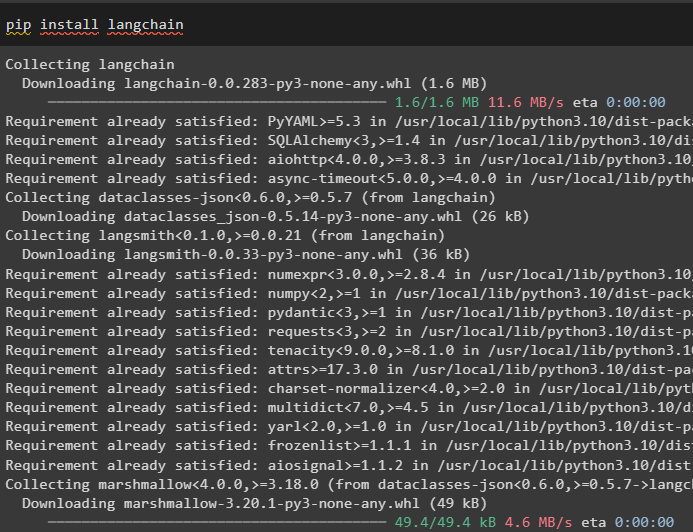

Paso 1: instalar paquetes

Primero, comience con el proceso instalando el módulo LangChain para obtener sus dependencias para crear y ejecutar LLMChains:

pip instalar cadena larga

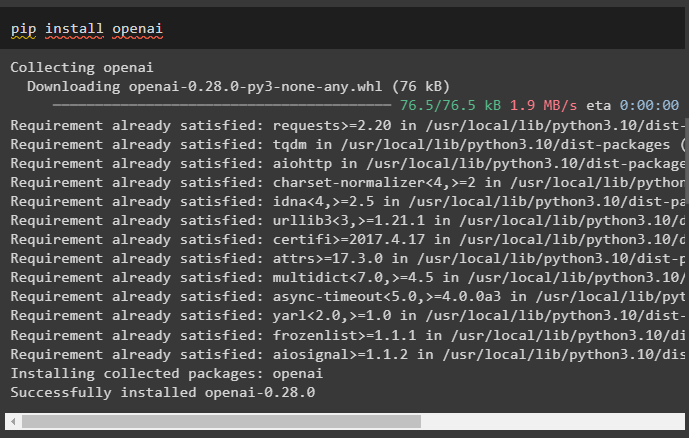

Instale el marco OpenAI usando el comando pip para que las bibliotecas usen la función OpenAI() para crear LLM:

instalación de pip en openai

Después de la instalación de los módulos, simplemente configurar el entorno variables usando la clave API de la cuenta OpenAI:

importar tú

importar conseguir pase

tú . alrededor de [ 'OPENAI_API_KEY' ] = conseguir pase . conseguir pase ( 'Clave API de OpenAI:' )

Paso 2: importar bibliotecas

Una vez que se complete la configuración y se instalen todos los paquetes necesarios, importe las bibliotecas necesarias para crear la plantilla de solicitud. Después de eso, simplemente cree el LLM usando el método OpenAI() y configure LLMChain usando los LLM y la plantilla de solicitud:

de cadena larga importar Plantilla de avisode cadena larga importar AbiertoAI

de cadena larga importar LLMChain

plantilla_indicador = '¿Dame un buen título para la empresa que fabrica {producto}?'

llm = AbiertoAI ( temperatura = 0 )

cadena_llm = LLMChain (

llm = llm ,

inmediato = Plantilla de solicitud. de la plantilla ( plantilla_indicador )

)

cadena_llm ( 'ropa colorida' )

Paso 3: ejecutar cadenas

Obtenga la lista de entrada que contiene varios productos producidos por la empresa y ejecute la cadena para mostrar la lista en la pantalla:

lista_entrada = [{ 'producto' : 'medias' } ,

{ 'producto' : 'computadora' } ,

{ 'producto' : 'zapatos' }

]

llm_chain. aplicar ( lista_entrada )

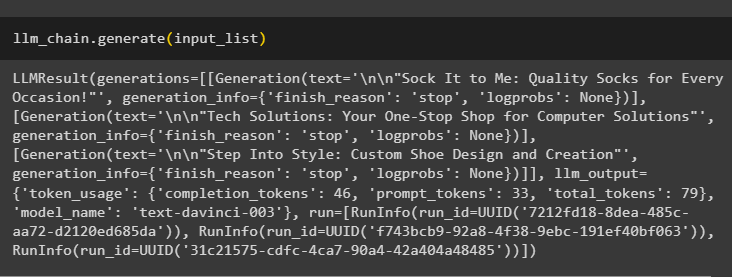

Ejecute el método generate() usando el lista_entrada con LLMChains para obtener el resultado relacionado con la conversación generada por el modelo:

llm_chain. generar ( lista_entrada )

Paso 4: usar entrada única

Agregue otro producto para ejecutar LLMChains usando solo una entrada y luego prediga que LLMChain genere la salida:

llm_chain. predecir ( producto = 'calcetines de colores' )Paso 5: usar múltiples entradas

Ahora, cree la plantilla para usar múltiples entradas para proporcionar el comando al modelo antes de ejecutar la cadena:

plantilla = '''Cuéntame un chiste de {adjetivo} sobre {sujeto}.'''inmediato = Plantilla de aviso ( plantilla = plantilla , variables_entrada = [ 'adjetivo' , 'sujeto' ] )

cadena_llm = LLMChain ( inmediato = inmediato , llm = AbiertoAI ( temperatura = 0 ) )

llm_chain. predecir ( adjetivo = 'triste' , sujeto = 'patos' )

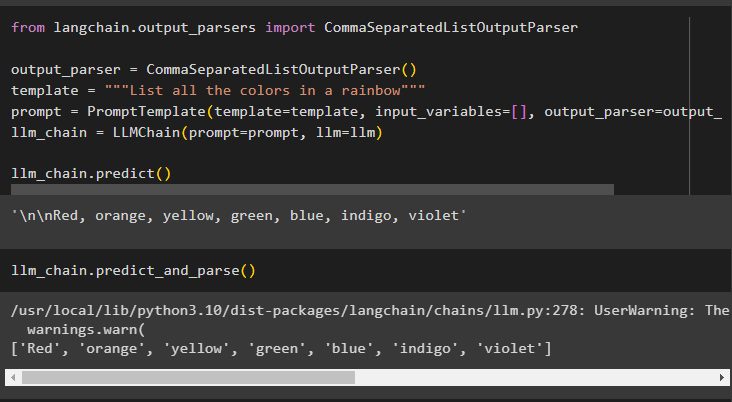

Paso 6: usar el analizador de salida

Este paso utiliza el método del analizador de salida para ejecutar LLMChain y obtener el resultado según el mensaje:

de cadena larga. analizadores_de_salida importar CommaSeparatedListOutputParseranalizador_salida = CommaSeparatedListOutputParser ( )

plantilla = '''Enumera todos los colores del arco iris'''

inmediato = Plantilla de aviso ( plantilla = plantilla , variables_entrada = [ ] , analizador_salida = analizador_salida )

cadena_llm = LLMChain ( inmediato = inmediato , llm = llm )

llm_chain. predecir ( )

Usar el método parse() para obtener el resultado generará una lista separada por comas de todos los colores del arco iris:

llm_chain. predecir_y_parse ( )

Paso 7: inicialización desde cadenas

Este paso explica el proceso de usar una cadena como mensaje para ejecutar LLMChain usando el modelo y la plantilla de LLM:

plantilla = '''Cuéntame un chiste de {adjetivo} sobre {sujeto}'''cadena_llm = LLMChain. de_cadena ( llm = llm , plantilla = plantilla )

Proporcione los valores de las variables en el mensaje de cadena para obtener el resultado del modelo ejecutando LLMChain:

llm_chain. predecir ( adjetivo = 'triste' , sujeto = 'patos' )Se trata de ejecutar LLMChains utilizando el marco LangChain.

Conclusión

Para crear y ejecutar LLMChains en LangChain, instale los requisitos previos como paquetes y configure el entorno utilizando la clave API de OpenAI. Después de eso, importe las bibliotecas necesarias para configurar la plantilla de solicitud y el modelo para ejecutar LLMChain utilizando las dependencias de LangChain. El usuario puede utilizar analizadores de salida y comandos de cadena para ejecutar LLMChains como se muestra en la guía. Esta guía ha detallado el proceso completo de ejecución de LLMChains en LangChain.