Sintaxis:

Como estamos familiarizados con ChatGPT, sabemos que esta plataforma es propiedad de la comunidad Open AI y proporciona herramientas, arquitecturas, API y varios marcos que podemos utilizar en la implementación de nuestras aplicaciones y los modelos de procesamiento de lenguaje natural. Open AI ofrece las API a través de las cuales podemos usar cualquier modelo de IA y NLP previamente entrenado de la plataforma Open AI y podemos hacer que funcionen para nuestras aplicaciones como, por ejemplo, para dar predicciones sobre datos en tiempo real. Asimismo, GPT4All también proporciona a sus usuarios la integración de sus modelos de IA preentrenados con diferentes aplicaciones.

El modelo GPT4All está entrenado con datos limitados en comparación con ChatGPT. También tiene algunas de sus limitaciones de rendimiento en comparación con ChatGPT, pero le permite al usuario usar su GPT privado en su hardware local y no requiere ninguna conexión de red. Con la ayuda de este artículo, conoceremos cómo podemos usar los modelos GPT4All en el script de Python, ya que GPT4All tiene enlaces oficiales con Python, lo que significa que también podemos usar e integrar los modelos GPT4All a través del script de Python.

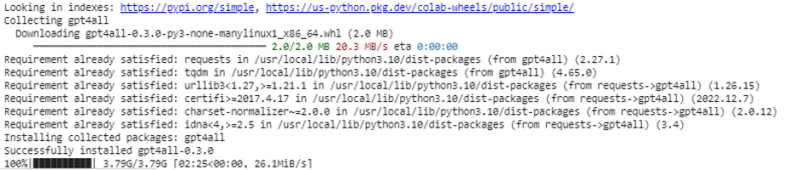

Todo requiere un comando en línea para instalar GPT4All para el IDE de Python. Entonces, podemos integrar tantos modelos de IA como nuestras aplicaciones. El comando para instalar este GPT4All en Python es como se muestra a continuación:

$ pip instalar gpt4all

Ejemplo 1:

Para comenzar con este ejemplo, necesitamos descargar e instalar Python en nuestros sistemas. Las versiones recomendadas de Python son la “versión 3.7” o las posteriores a esta versión. Otra forma de trabajar con Python para evitar el largo proceso de instalación de la 'configuración de Python' en nuestros sistemas es usar 'Google Colab', que es un entorno basado en la nube para Python. Podemos ejecutar este entorno en cualquier navegador web y podemos construir los modelos de inteligencia artificial y aprendizaje automático. Los ejemplos que implementaremos aquí se ejecutan en Google Colab.

Este ejemplo cubre el método para instalar GPT4All en Python y cómo usar sus modelos previamente entrenados. Comenzamos instalando primero el GPT4All. Para eso se ejecuta el comando que mencionamos anteriormente. Con la ejecución del comando, GPT4All junto con sus paquetes y marcos se descargan e instalan.

Ahora, avanzamos. Desde GPT4All, importamos el “GPT4All”. Esto agrega todos los modelos pre-entrenados de GPT4All al proyecto. Ahora, podemos utilizar cualquier modelo único y hacer que haga las predicciones para nuestra aplicación. Una vez que importamos el paquete GPT4All, ahora es el momento de llamar a esta función y usar el modelo GPT4All que da la salida para la 'finalización del chat'.

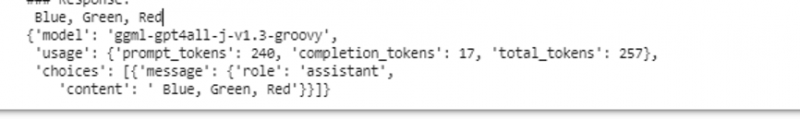

En otras palabras, si le preguntamos algo a ese modelo en la entrada, lo devuelve en la salida. El modelo que usamos aquí es 'ggml-gpt4all-j-v1.3-groovy'. Estos modelos ya están almacenados en el caché de GPT4All. Estos modelos los podemos conseguir desde este enlace” https://github.com/nomic-ai/gpt4all/tree/main/gpt4all-chat ” para descarga manual. Si el modelo ya está presente en el caché GPT4All, simplemente llamamos al nombre del modelo y lo especificamos como parámetros de entrada a la función 'GPT4All()'. Si lo descargamos manualmente con éxito, le pasamos la ruta a la carpeta donde se encuentra el modelo. Dado que este modelo es para completar mensajes, la sintaxis de este modelo es la siguiente:

$ Chat_completion (mensajes)Los mensajes son una lista de diccionarios y cada diccionario debe contener una clave de 'función' con un valor de usuario, sistema o asistente, y el contenido de la 'clave' que tiene el valor como cadena. En este ejemplo, especificamos el contenido como 'nombre de tres colores' y la clave de función como 'usuario'.

$modelo= GPT4All('ggml-gpt4all-j-v1.3-groovy')$mensajes = [{'rol': 'usuario', 'contenido': 'Nombre 3 flores'}]

Después de esta especificación, llamamos a la función “chat_completion()” con el modelo. El código para esto se muestra en el siguiente resultado:

$ !pip instalar gpt4alldesde gpt4all importar GPT4All

modelo = GPT4All('ggml-gpt4all-j-v1.3-groovy')

mensajes = [{'rol': 'usuario', 'contenido': 'Nombra tres colores'}]

modelo.chat_completion(mensajes)

Después de la ejecución de este ejemplo, el modelo devuelve tres colores como respuesta a la entrada.

Ejemplo 2:

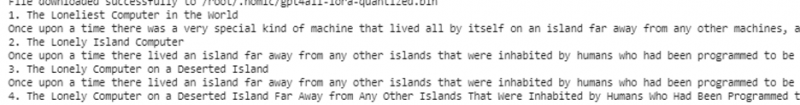

Cubrimos otro ejemplo donde descubrimos otro método para usar GPT4All en Python. Esto se puede hacer utilizando los enlaces oficiales para Python que proporciona 'Nomic', que es una comunidad de IA de código abierto, y ejecuta GPT4All. Usando el siguiente comando, integramos 'nomic' en nuestra consola de Python:

$ pip instalar nomicUna vez instalado, importamos el GPT4All desde “nomic.gpt4all”. Después de importar GPT4All, inicializamos GPT4All con la función 'abrir()'. Luego, llamamos a la función “prompt()” y le pasamos un aviso a esta función. Luego, se genera una respuesta de aviso basada en el aviso que hemos dado como entrada al modelo de aviso.

!pip instalar nomicdesde nomic.gpt4all importar GPT4All

# Inicializar el modelo GPT4All

iniciar = GPT4All()

initiate.open()

# Generar una respuesta basada en el aviso

model_response = iniciar.prompt('escribir una historia corta sobre una computadora)

# mostrando la respuesta generada

imprimir (modelo_respuesta)

El resultado muestra la respuesta rápida del modelo que generamos usando el modelo GPT4All previamente entrenado en Python. Si queremos saber más acerca de los modelos y cómo podemos utilizar estos modelos para generar las respuestas, o en palabras simples, si queremos obtener conocimiento sobre la sintaxis para generar las respuestas de estos modelos, podemos obtener más ayuda de la GPT4Todos los detalles de la documentación técnica.

Conclusión

GPT4All todavía se esfuerza por obtener precisión en el rendimiento. Está a cargo de la plataforma nomic AI, que tiene como objetivo proporcionar chatbots artificialmente inteligentes a sus usuarios en las CPU de nivel de consumidor, ya que GPT4All funciona sin ninguna conexión de red ni GPU. Este artículo nos ilustra para usar PyGPT4All de manera competente en un entorno de Python y para crear una interacción entre nuestras aplicaciones y los modelos de IA de GPT4All previamente entrenados. Cubrimos dos métodos diferentes sobre cómo instalar GPT4All en Python en esta guía.