Limpiar los datos con Python y Pandas

Los datos son como los pilares de la toma de decisiones hoy en día. Pero imagina tener un grupo de bloques de diferentes formas y tamaños de esta colección; Es difícil construir algo significativo. Aquí es donde la limpieza de datos entra en juego.

Esta guía explora cómo limpiar los datos utilizando el marco de Python, que es Pandas, para una mejor toma de decisiones. La limpieza de datos también es fundamental, teniendo en cuenta que estamos trabajando con una lista de registros de ventas de una tienda. Es posible que notemos que faltan algunos números, fechas extrañas y elementos repetidos sin ningún motivo en la lista. Si hacemos cálculos o registros basados en esta información, estos problemas pueden arruinar nuestros cálculos y predicciones. La limpieza de datos ayuda a solucionar estos problemas, garantizando que nuestros datos sean precisos y estén listos para usar.

La limpieza de datos incluye manejar los datos que faltan y qué hacer cuando faltan algunos datos, eliminar los duplicados, deshacerse de las cosas copiadas, corregir los tipos de datos, asegurarse de que todo esté en el formato adecuado y lidiar con valores atípicos o manejar los números. que no encajan. Estos errores hacen que los datos parezcan iguales y estandarizan su apariencia.

Para comenzar, primero nos aseguramos de tener Python y Pandas instalados. Esto lo podemos hacer escribiendo los comandos en la terminal o símbolo del sistema de nuestra computadora. Para implementar los códigos que se mencionan en esta guía, podemos usar el IDE de Python Pycharm que está instalado en nuestro sistema o la plataforma Python en línea que es 'Google Colab' e instalar los comandos 'pip' para instalar las bibliotecas importantes.

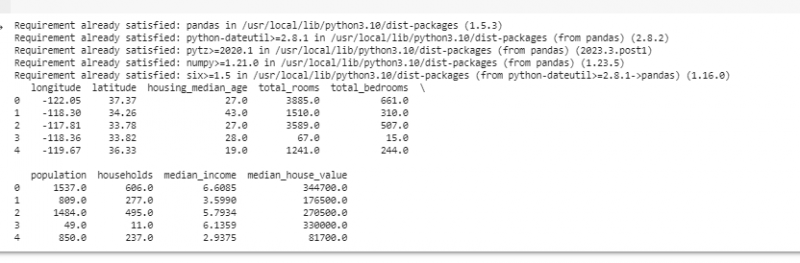

Ahora, importemos Pandas y carguemos nuestros datos de muestra. Para este ejemplo, utilizamos Google Colab para ejecutar los códigos. Entonces, primero importamos Pandas ingresando el siguiente comando:

! pip instalar pandas

importar pandas como PD

importar engordado como p.ej.

Luego, cargamos el conjunto de datos que queremos mostrar usando el método pd.read() que toma la ruta del archivo como parámetro de entrada.

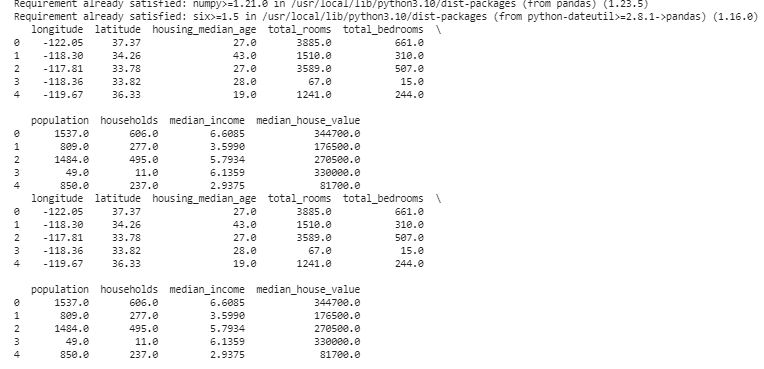

# Cargar el conjunto de datosdatos = PD. leer_csv ( '/content/sample_data/california_housing_test.csv' )

# Mostrar las primeras filas

imprimir ( datos. cabeza ( ) )

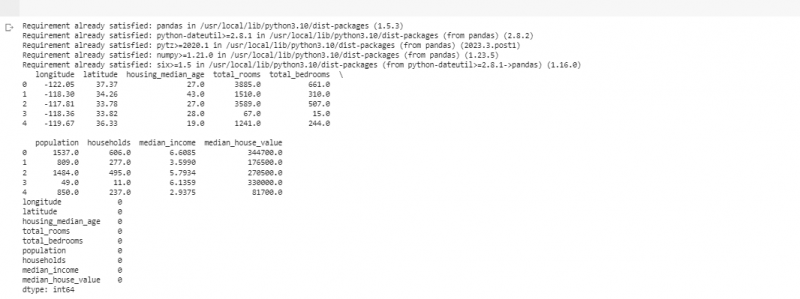

En el siguiente ejemplo, utilizamos los datos sobre las ventas en una tienda pequeña. Para manejar los datos faltantes, a veces falta información en nuestros datos. A estas partes faltantes las llamamos 'NaN' (que significa 'no es un número'). Para encontrar estos valores faltantes en el script de Python, primero cargamos el conjunto de datos como lo hicimos en el ejemplo anterior. Luego, encontramos los valores faltantes en el conjunto de datos usando la función “missing_values = data.isnull().sum()”. Esta función encuentra todos los valores faltantes en el conjunto de datos. Luego, los mostramos usando la función print().

! pip instalar pandasimportar pandas como PD

importar engordado como p.ej.

# Cargar el conjunto de datos

datos = PD. leer_csv ( '/content/sample_data/california_housing_test.csv' )

# Mostrar las primeras filas

imprimir ( datos. cabeza ( ) )

# Comprobar valores faltantes

valores faltantes = datos. es nulo ( ) . suma ( )

# Mostrar el recuento de valores faltantes por columna

imprimir ( valores faltantes )

Después de encontrar datos faltantes en cualquier fila que ejecute el código mencionado anteriormente, podemos eliminar esas filas ya que esas filas no tienen muchos datos útiles. Incluso podemos adivinar esos valores faltantes y completar los espacios en blanco con conjeturas fundamentadas estimando los datos basados en el tiempo en función de puntos cercanos.

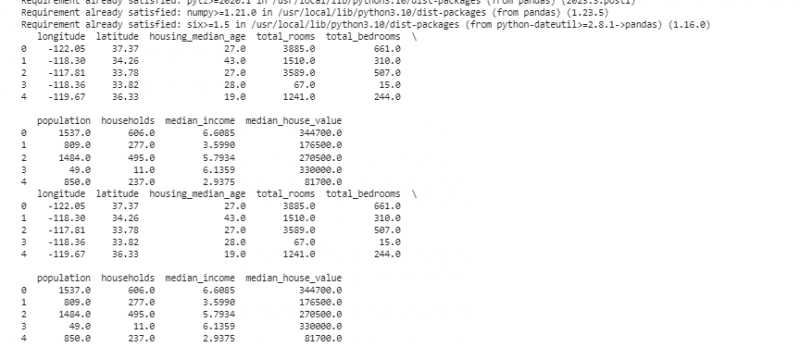

Ahora, eliminamos los duplicados que son copias de lo mismo porque pueden confundir nuestro análisis. Para encontrar los valores duplicados en el conjunto de datos, utilizamos la función 'duplicate_rows = data[data.duplicated()]'. Para eliminar estos valores duplicados, llamamos a la función data.drop_duplicates(). Podemos encontrarlos y eliminarlos usando el siguiente código:

! pip instalar pandasimportar pandas como PD

importar engordado como p.ej.

# Cargar el conjunto de datos

datos = PD. leer_csv ( '/content/sample_data/california_housing_test.csv' )

# Mostrar las primeras filas

imprimir ( datos. cabeza ( ) )

# Comprobar si hay filas duplicadas

filas_duplicadas = datos [ datos. duplicado ( ) ]

# Eliminar duplicados

datos = datos. drop_duplicados ( )

# Mostrar las primeras filas después de eliminar duplicados

imprimir ( datos. cabeza ( ) )

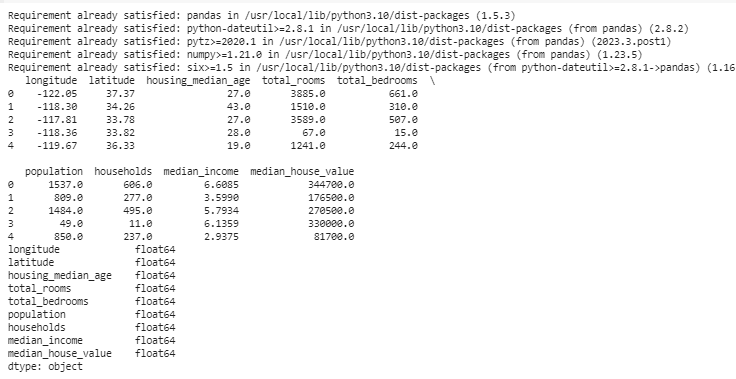

Los tipos de datos deciden qué datos se pueden almacenar para corregir los tipos de datos. Es fundamental tener el tipo adecuado para cada tipo de datos. Por ejemplo, las fechas deben tener el tipo de datos fecha y hora y los números deben tener un tipo de datos como int, float, etc. Para verificar los tipos de datos de nuestros datos, usamos la función 'data.dtypes'. Esta función se puede utilizar de la siguiente manera:

! pip instalar pandasimportar pandas como PD

importar engordado como p.ej.

# Cargar el conjunto de datos

datos = PD. leer_csv ( '/content/sample_data/california_housing_test.csv' )

# Mostrar las primeras filas

imprimir ( datos. cabeza ( ) )

# Verifique los tipos de datos de cada columna

tipos de datos = datos. tipos

# Mostrar tipos de datos

imprimir ( tipos de datos )

Si encontramos algún problema, podemos cambiar el tipo de datos usando Pandas. Por ejemplo, podemos convertir las fechas en un formato de fecha. El atributo 'dtypes' de un DataFrame proporciona información sobre los tipos de datos de cada columna. Si encontramos que el tipo de datos no coincide, podemos usar la función astype() de Pandas para convertir las columnas a los tipos deseados.

Después de los tipos de datos, a veces nos encontramos con valores atípicos, que son valores muy diferentes de los demás. Pueden estropear nuestros cálculos. Para lidiar con valores atípicos, definimos una función que utiliza la función de puntuación z “np.abs(stats.zscore(data))” que compara los valores que existen en nuestros datos con el valor umbral. Cualquier valor distinto del rango de este umbral se considera un valor atípico . Veamos cómo encontrar y manejar los valores atípicos:

! pip instalar pandasimportar pandas como PD

importar engordado como p.ej.

# Cargar el conjunto de datos

datos = PD. leer_csv ( '/content/sample_data/california_housing_test.csv' )

# Mostrar las primeras filas

imprimir ( datos. cabeza ( ) )

de picante importar estadísticas

definición detectar_valores atípicos ( datos ) :

puntuaciones_z = p.ej. abdominales ( estadísticas. puntuación z ( datos ) )

devolver p.ej. dónde ( puntuaciones_z > 3 )

# Detectar y manejar valores atípicos en la columna 'Ventas'

valores atípicos = detectar_valores atípicos ( datos [ 'longitud' ] )

datos [ 'longitud' ] . lugar [ valores atípicos ] = datos [ 'longitud' ] . mediana ( )

# Detectar y manejar valores atípicos en la columna 'Unidades vendidas'

valores atípicos = detectar_valores atípicos ( datos [ 'latitud' ] )

datos [ 'latitud' ] . lugar [ valores atípicos ] = datos [ 'latitud' ] . mediana ( )

# Mostrar las primeras filas después de manejar valores atípicos

imprimir ( datos. cabeza ( ) )

Usamos un método simple para encontrar y corregir los valores atípicos en el código anterior. Implica reemplazar los valores extremos por el valor medio de los datos. Este código utiliza el método de puntuación Z para detectar valores atípicos en las columnas de 'longitud' y 'latitud' de nuestro conjunto de datos. Los valores atípicos se reemplazan con los valores medianos de sus respectivas columnas.

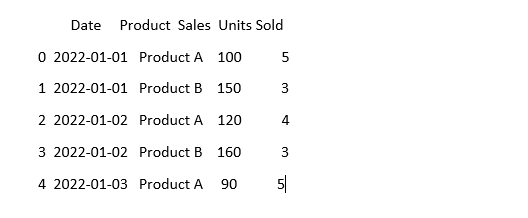

Para que los datos parezcan iguales, a veces pueden verse diferentes incluso si significan lo mismo. Por ejemplo, las fechas se pueden escribir en varios formatos. La estandarización implica garantizar un formato y una representación de datos consistentes. Esto puede incluir formatear las fechas, convertir el texto a minúsculas o normalizar los valores numéricos. Estandaricemos la columna 'Fecha' en nuestro conjunto de datos y asegurémonos de que nuestros datos tengan el mismo aspecto:

importar pandas como PDimportar engordado como p.ej. # Importar números

# Cargar los datos

datos = PD. leer_csv ( 'datos_ventas.csv' )

# Hacer que la columna 'Fecha' parezca coherente

datos [ 'Fecha' ] = PD. hasta_fechahora ( datos [ 'Fecha' ] )

# Mira cómo se ve ahora

imprimir ( datos. cabeza ( ) )

En este ejemplo, estandarizamos el formato de fecha en nuestro conjunto de datos al formato de fecha y hora de Python usando la función 'pd.to_datetime(data['Date'])'. Al convertir la columna 'Fecha' al mismo formato, facilitamos el trabajo con estos datos. El resultado muestra las primeras filas del conjunto de datos con la columna 'Fecha' estandarizada.

Conclusión

En nuestro viaje a través de la limpieza de datos utilizando Python y Pandas, aprendimos cómo mejorar nuestros datos para el análisis. Comenzamos entendiendo por qué es tan importante limpiar los datos. Nos ayuda a tomar mejores decisiones. Exploramos cómo lidiar con los datos faltantes, eliminar los duplicados, corregir los tipos de datos, manejar los valores atípicos y hacer que nuestros datos tengan el mismo aspecto. Con estas habilidades, estamos mejor preparados para convertir datos confusos en algo en lo que podamos confiar y utilizar para descubrir información importante. La limpieza de datos es un proceso continuo, como mantener nuestra habitación ordenada, y hace que nuestro proceso de análisis de datos sea más exitoso.