En este blog, cubriremos el contenido que se proporciona a continuación:

- ¿Cómo personalizar la generación de texto cargando el modelo con la función “pipeline” de Transformers?

- ¿Cómo utilizar un modelo basado en transformador para generar texto en PyTorch?

- ¿Cómo utilizar un modelo basado en transformador para generar texto en TensorFlow?

¿Cómo personalizar la generación de texto cargando el modelo con la función “pipeline” de Transformers?

El ' tubería La función 'se utiliza para descargar automáticamente el modelo de IA previamente entrenado de acuerdo con los requisitos del usuario. Para utilizar esta función en particular, los usuarios deben instalar el ' transformadores 'Paquetes. Este paquete brinda acceso a modelos de última generación basados en Transformer que pueden realizar análisis de sentimiento, así como muchos otros. Procesamiento del lenguaje natural (PNL) tareas.

Para ver la demostración práctica del escenario descrito anteriormente, continúe con los pasos que se indican a continuación.

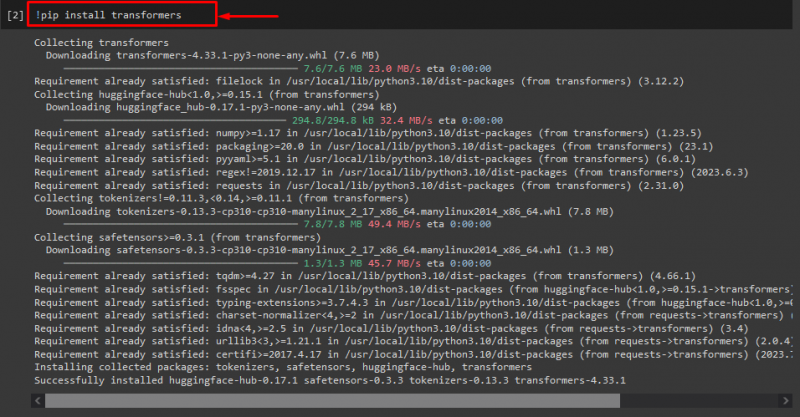

Paso 1: Instale los paquetes 'transformers'

Inicialmente ejecute el comando “! pepita' comando para instalar los paquetes de transformador:

! transformadores de instalación de tuberías

Como puede ver, el paquete especificado se ha instalado correctamente:

Paso 2: Importar modelo basado en transformador

Luego, importe el modelo basado en transformador requerido. Para hacerlo, primero, importe el ' tubería ' función de ' transformadores ”. A continuación, utilice la función importada y pase el ' generación de texto 'como argumento junto con el nombre del modelo requerido' gpt2 ”. A continuación, páselos al “ generar ' variable:

de transformadores importar tubería

generar = tubería ( 'generación de texto' , modelo = 'gpt2' )

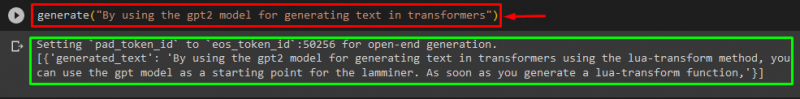

Paso 3: generar texto personalizado

Ahora, pase el texto deseado como argumento al “ generar ”. Como se muestra abajo:

generar ( 'Usando el modelo gpt2 para generar texto en transformadores' )Según el resultado proporcionado, el archivo preentrenado descargado ' gpt3 'El modelo se ha generado el texto correctamente:

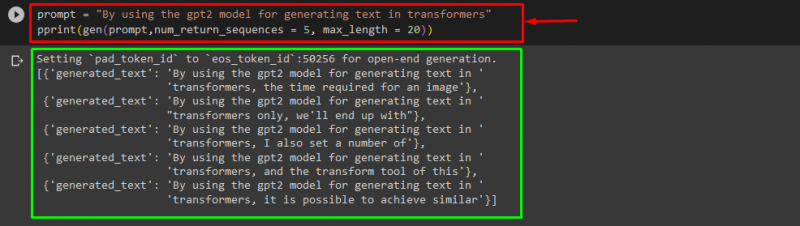

También puede utilizar otros argumentos, como:

inmediato = 'Usando el modelo gpt2 para generar texto en transformadores'imprimir ( gen ( inmediato , num_return_sequences = 5 , longitud máxima = 20 ) )

Aquí:

- “ inmediato ”se utiliza como argumento que ofrece información.

- “ num_return_sequence El argumento 'se utiliza para generar el número de secuencias del texto proporcionado.

- “ longitud máxima El argumento 'se utiliza para especificar la longitud del texto generado. En nuestro caso, se limita a “ 30 ” tokens(palabras o puntuación):

Nota: El texto personalizado será una continuación del mensaje especificado que se basa en los datos de entrenamiento del modelo.

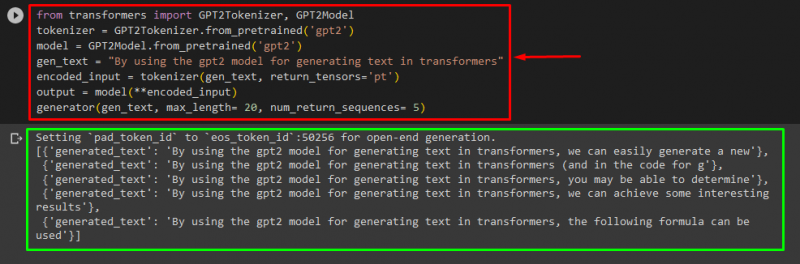

¿Cómo utilizar un modelo basado en transformador para generar texto en PyTorch?

Los usuarios también pueden personalizar el texto en ' PyTorch ' Cuál es el ' Antorcha ”marco de aprendizaje automático basado. Se utiliza para diferentes aplicaciones, como PNL y visión por computadora. Para utilizar el modelo basado en transformador para personalizar el texto en PyTorch, primero importe el archivo ' Tokenizador GPT2 ' y ' Modelo GPT2 'Funciona desde el' transformadores ”:

de transformadores importar Tokenizador GPT2 , Modelo GPT2Luego, utilice el botón ' Tokenizador GPT2 'Tokenizer según nuestro modelo previamente entrenado deseado llamado' gpt2 ”:

tokenizador = Tokenizador GPT2. from_pretrained ( 'gpt2' )Luego, crear instancias de los pesos a partir de un modelo previamente entrenado:

modelo = Modelo GPT2. from_pretrained ( 'gpt2' )A continuación, declara un “ gen_texto ”variable que contiene el texto que queremos personalizar:

gen_texto = 'Usando el modelo gpt2 para generar texto en transformadores'Ahora, pasa el “ gen_texto ' y ' return_tensors='pt' 'como argumento que generará el texto en PyTorch y almacenará el valor generado en el' entrada_codificada ' variable:

entrada_codificada = tokenizador ( gen_texto , tensores_de_retorno = 'pt' )Por último, pase el “ entrada_codificada 'Variable que contiene el texto personalizado en el' modelo ”como parámetro y obtener la salida resultante usando el botón “ longitud máxima 'argumento que se establece en' 20 'lo que indica que el texto generado se limitará a los tokens proporcionados, el' num_return_sequences ' que se establece en ' 5 ”que muestra que el texto generado se basará en 5 secuencias de texto:

producción = modelo ( **entrada_codificada )generador ( gen_texto , longitud máxima = 20 , num_return_sequences = 5 )

Producción

¿Cómo utilizar un modelo basado en transformador para generar texto en TensorFlow?

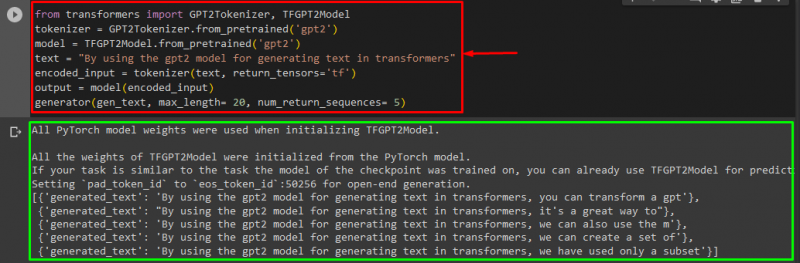

Para generar el texto en Transformers, el ' TensorFlow También se utilizan marcos de aprendizaje automático basados en ”. Para hacerlo, primero, importe las funciones requeridas, como ' Tokenizador GPT2 ' y ' Modelo TFGPT2 ' desde el ' transformadores ”. El resto del código es el mismo que el anterior, solo usamos el ' Modelo TFGPT2 función 'en lugar de' Modelo GPT2 ' función. De la siguiente manera:

de transformadores importar Tokenizador GPT2 , Modelo TFGPT2tokenizador = Tokenizador GPT2. from_pretrained ( 'gpt2' )

modelo = Modelo TFGPT2. from_pretrained ( 'gpt2' )

texto = 'Usando el modelo gpt2 para generar texto en transformadores'

entrada_codificada = tokenizador ( texto , tensores_de_retorno = 'tf' )

producción = modelo ( entrada_codificada )

generador ( gen_texto , longitud máxima = 20 , num_return_sequences = 5 )

Como puede ver, el texto personalizado se ha generado correctamente:

¡Eso es todo! Hemos elaborado más detalles sobre la personalización de la generación de texto en Transformers.

Conclusión

Para personalizar la generación de texto en Transformers, existen diferentes formas, como cargar el modelo con la función de canalización, usar el modelo basado en transformador en “ PyTorch ' y ' TensorFlow ”que se basan en marcos de aprendizaje automático. En esta guía, proporcionamos información breve junto con una demostración práctica de cómo personalizar la generación de texto en Transformers.