La función pipeline() es una parte integral de la biblioteca Transformer. Se necesitan varias entradas en las que podemos definir una tarea de inferencia, modelos, mecanismo de tokenización, etc. Una función pipeline() se utiliza principalmente para realizar tareas de PNL en uno o varios textos. Realiza un preprocesamiento de la entrada y un posprocesamiento basado en el modelo para generar resultados legibles por humanos y predicciones precisas con la máxima precisión.

Este artículo cubre los siguientes aspectos:

- ¿Qué es la biblioteca de conjuntos de datos de Hugging Face?

- ¿Cómo aplicar tuberías en un conjunto de datos en Hugging Face?

¿Qué es la biblioteca de conjuntos de datos de Hugging Face?

Una biblioteca de conjuntos de datos de Hugging Face es una API que contiene varios conjuntos de datos públicos y proporciona una forma sencilla de descargarlos. Esta biblioteca se puede importar e instalar en la aplicación utilizando el botón ' pepita ' dominio. Para ver una demostración práctica para descargar e instalar conjuntos de datos de la biblioteca Hugging Face, visite este Enlace de Google Colab. Puede descargar múltiples conjuntos de datos desde Centro de conjunto de datos de cara de abrazo.

Obtenga más información sobre el funcionamiento de la función pipeline() consultando este artículo “ ¿Cómo utilizar la función Pipeline() en Transformers? ”.

¿Cómo aplicar tuberías en un conjunto de datos en Hugging Face?

Hugging Face proporciona varios conjuntos de datos públicos diferentes que se pueden instalar fácilmente mediante código de una línea. En este artículo, veremos una demostración práctica de la aplicación de canalizaciones a estos conjuntos de datos. Hay dos formas en que se pueden implementar canalizaciones en el conjunto de datos.

Método 1: uso del método de iteración

La función pipeline() también se puede iterar sobre un conjunto de datos y un modelo. Para ello, siga los pasos que se mencionan a continuación:

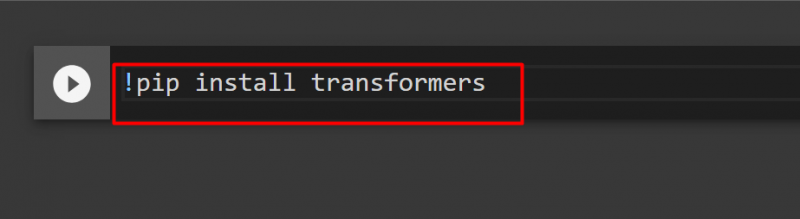

Paso 1: Instale la biblioteca Transformer

Para instalar la biblioteca Transformer, proporcione el siguiente comando:

!pip instalar transformadores

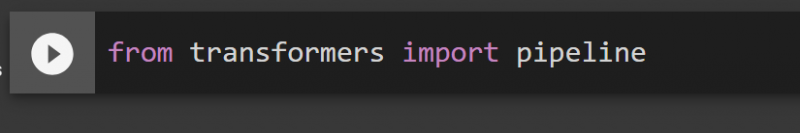

Paso 2: Importar canalizaciones

Podemos importar la tubería desde la biblioteca Transformer. Para ello, proporcione el siguiente comando:

de tubería de importación de transformadores

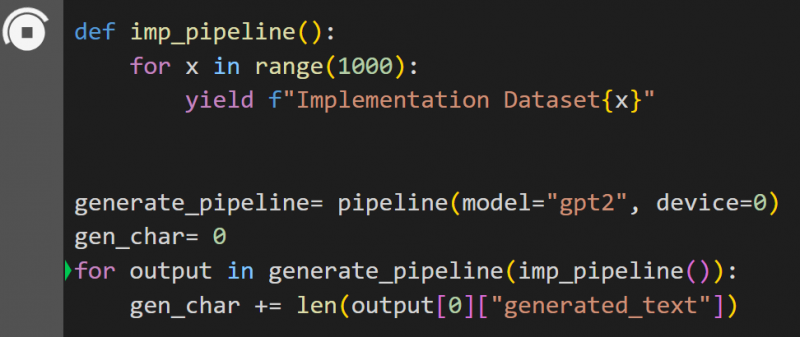

Paso 3: implementar la canalización

Aquí, la función pipeline() se implementa en el modelo ' gpt2 ”. Puede descargar modelos desde el Centro de modelos de cara abrazada:

definición imp_pipeline():para x en el rango (1000):

rendimiento f'Conjunto de datos de implementación{x}'

generate_pipeline= canalización(model='gpt2', dispositivo=0)

gen_char= 0

para salida en generate_pipeline(imp_pipeline()):

gen_char += len(salida[0]['texto_generado'])

En este código, el “ generar_tubería ' es una variable que contiene la función pipeline() con modelo ' gpt2 ”. Cuando se llama con el “ imp_pipeline() ”, reconoce automáticamente los datos que aumentan con el rango especificado a 1000:

Esto llevará algún tiempo entrenar. El enlace a la Google Co. también se da.

Método 2: usar la biblioteca de conjuntos de datos

En este método, demostraremos la implementación de la canalización utilizando la biblioteca 'conjuntos de datos':

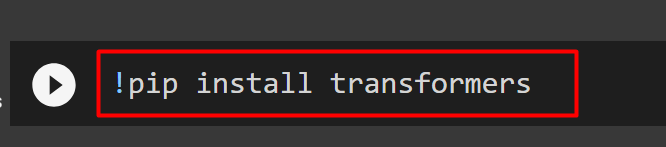

Paso 1: instalar el transformador

Para instalar la biblioteca Transformer, proporcione el siguiente comando:

!pip instalar transformadores

Paso 2: instalar la biblioteca de conjuntos de datos

Como el “ conjuntos de datos La biblioteca contiene todos los conjuntos de datos públicos, podemos instalarla usando el siguiente comando. Al instalar el “ conjuntos de datos ”, podemos importar directamente cualquier conjunto de datos proporcionando su nombre:

!pip instalar conjuntos de datos

Paso 3: canalización del conjunto de datos

Para crear una canalización en el conjunto de datos, utilice el siguiente código. KeyDataset es una característica que genera solo aquellos valores que interesan al usuario:

desde transformadores.pipelines.pt_utils importar KeyDatasetde tubería de importación de transformadores

desde conjuntos de datos importar load_dataset

gen_pipeline = tubería(model='hf-internal-testing/tiny-random-wav2vec2', dispositivo=0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]') para salida en gen_pipeline(KeyDataset(loaddataset, 'audio')):

print('Imprimiendo el resultado ahora')

imprimir ('----------------')

imprimir (salida)

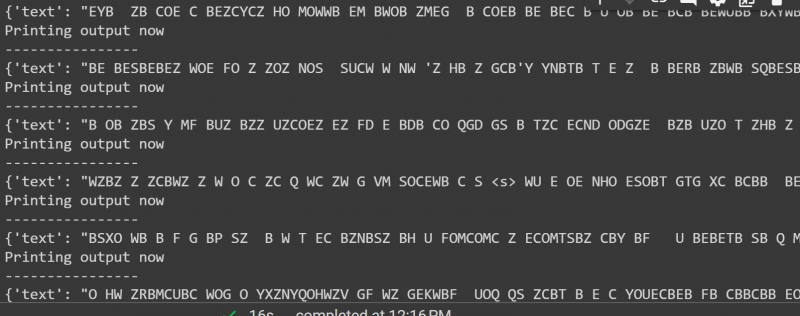

El resultado del código anterior se proporciona a continuación:

Eso es todo de esta guía. El enlace a la Google Co. También se menciona en este artículo.

Conclusión

Para aplicar canalizaciones en el conjunto de datos, podemos iterar sobre un conjunto de datos utilizando una función canalización() o utilizar la función ' conjuntos de datos ' biblioteca. Hugging Face proporciona el enlace del repositorio de GitHub a sus usuarios tanto para conjuntos de datos como para modelos que se pueden utilizar según los requisitos. Este artículo proporciona una guía completa para aplicar canalizaciones en un conjunto de datos en Transformers.